AIを使って、人間のように視覚情報から物体の柔らかさや崩れやすさを捉えること技術が開発されました。ロボットが物体を壊さないように丁寧に扱うことが可能になると期待されます。

人間は過去の経験に基づいて視覚情報から別の感覚を想起することができます。つまり、見た目だけで柔らかいものや崩れやすいものを丁寧に操作することを意識します。

しかしロボットは視覚センサーだけではこのような感覚を再現することは難しく、一般的には物体と接触後に力覚センサーで判断していました。

この判断方法では、対象物が崩れてしまうなど物体に接触してからでは遅い場合は器用な作業をすることは困難です。

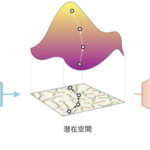

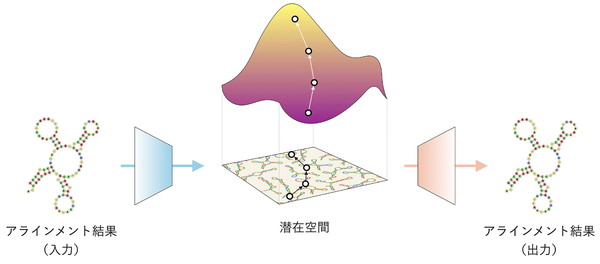

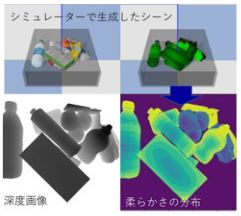

今回、産業技術総合研究所は視覚情報から物体間に働く力を想起するAI技術を開発。物理シミュレーター上で物体間にかかる力を可視化した仮想的な経験データを構築し、この仮想的な経験から視覚と別の感覚(力)の関係をAIが学習することでこれを実現しました。

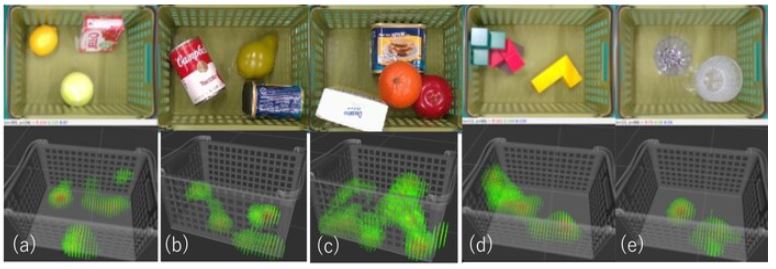

実験では、カメラ1台を使って未知の物体間に働く力分布をリアルタイムで可視化することに成功。

また、力分布を理解したロボットが周辺の物体の損傷が小さくなるように指定された対象物を持ち上げるなど、人間らしい推論に基づいた行動をとることを確認しました。

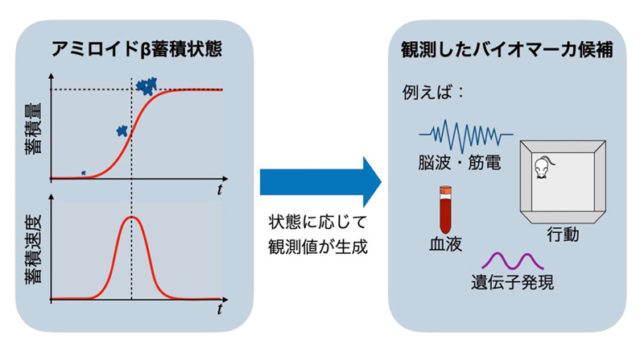

図では、カゴの中にある物体が周囲の物体と接触することで生じる力の大きさを、緑から赤の色で表しています。赤に近いほど大きな力がかかっていることを表しています。

今後、この技術はロボットによる丁寧な物体操作や自動運転における事故予測などに役立つことが期待されるとしています。

人間らしい「視覚から物体間に働く力を想起する能力」をAIが再現することに成功