米国ラスベガスで「CES 2018」が開催されているが、IntelのCEOであるBrian Krzanich氏の講演内容が注目を浴びている。Intelが考える自動運転車向けのプラットフォームでは、中心となるのは高機能な各種センサーではなく、「カメラ」なのだという。

運転を自動化するためには、車両の周囲の環境を把握して、起こりうるありとあらゆる状況を評価して、そして最善とみなされる一連の操作を選択する能力が必要となる。車両はさまざまなスピードで道路上を走行しているため、膨大な量のデータポイントを次々と処理し続けて、絶えず変化する環境に迅速に対応しなければならない。

Intelでは、自動運転車向けの開発プラットフォーム「Intel GO 」を開発しており、2018年に発売予定だという。

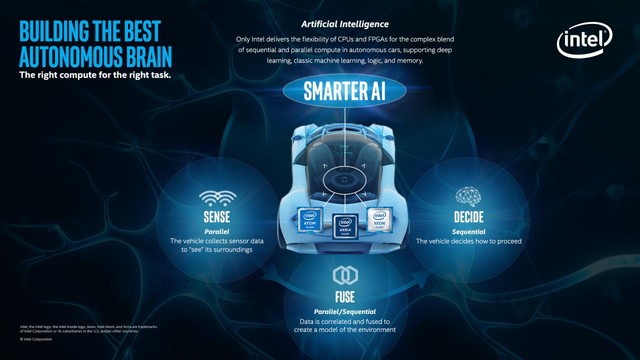

自動運転に必要な計算は、知覚、融合、そして決断という3つの段階に分割できる。(インテルGO 車載機器用ソリューション)

自動車は最初に数十ものセンサーから得られたデータによって周囲を認識する。そして次の段階ではデータを相互に関連させて融合し、環境モデルを作成する。最後に自動車は処理方法を決定する。

Intel GOはこれらすべての処理を効率よく実行するためのプラットフォームとなるわけだが、驚くほどシンプルで、そして「ビジョンファースト」の哲学が組み込まれているという。(自動運転ではカメラを重視、CESでIntelが基調講演)

人間が自動車を運転するとき、運転者は自分の目を使って周囲の状況を確認して運転操作を絶え間なく判断する。

自動運転においても同様で、車両の周囲の環境を何らかの方法で細かく認識して状況を把握しなければならない。このとき、主に使用されるのはカメラ、レーダー、そしてライダーとなる。

レーダーは、物体に向かって電波を発射して跳ね返ってくるまでの時間から物体の存在する方向そして距離を測定することができる。

ライダーとは「LiDAR」つまり「Light Detection and Ranging」の略語であって、電波のかわりに光を使って物体の検知と距離を測定することができる装置のこと。ビームを細く絞ることで電波より精密に物体の存在を検知することが可能になる。(自動運転用センサーで「ライダー」が台風の目に)

このように、自動運転車では車両の周囲の状況を把握するために複数のセンサーからのデータを統合するが、Intelは今後の開発において「カメラファースト」の戦略を進めているという。

上でも述べたように、車両の周囲の環境を正確に把握するためにはどの方向にどれくらい離れた物体があるかを認識する必要がある。そのためにレーダーやライダーが有用だが、もし自動運転車を量産するのであれば、これらの装置がとても高価であることが大きな問題となってくる。

自動運転車の開発ではWaymoやUberが開発を急いでいるが、これらの企業が最初に目指しているのは量産用の車両ではなくて、事業用の自動運転車なのかも知れない。

何年先になるかはわからないが、いずれ自動運転車を量産することを考えると、コストの問題は避けては通ることができない問題だ。その意味では、Intelはより長期的な視点に立っているのかも知れない。

レーダーやライダーを使用せずに、カメラだけで物体までの距離を捉える技術については、アウディが開発を進めている。(自動運転の実現に向けたアウディの技術、AIと単眼カメラでクルマ周辺の3Dモデルを構築する)

車両の前方に設置されたわずか一台のカメラで前方約120度の範囲を捉えるもので、撮影された画像をAIで解析することで、車両の周囲について精密な3D環境モデルを構築する。

このシステムでは1台のカメラで撮影された画像を使って画像中に存在するそれぞれの物体までの距離情報についても推定してみせる。

もちろん、実際にはカメラだけで周囲の状況を高精度に把握することは難しく、レーダーやライダーからの情報とミックスするのが現実的な方法となるにしても、メインとなるのは「カメラ」だというのがIntelの開発構想になるようだ。

Intelは、「カメラは自動運転車が走行路の地形やその他の静的な状況に確実に対応できる唯一のリアルタイムセンサーだ。カメラは最も低いコストで最高の性能データを自動運転車に提供できる」と主張している。